Вместе с презентацией Instinct MI300A и Instinct MI300X AMD на прошлой неделе представила впечатляющие данные о производительности. Согласно им, ускоритель Instinct MI300X как минимум не уступает H100 от NVIDIA.

Вместе с презентацией Instinct MI300A и Instinct MI300X AMD на прошлой неделе представила впечатляющие данные о производительности. Согласно им, ускоритель Instinct MI300X как минимум не уступает H100 от NVIDIA.

Однако теперь NVIDIA опровергла заявления AMD и опубликовала в блоге новые цифры, которые также учитывают и ускоритель Instinct MI300X. Здесь вновь становится очевидным важность оптимизации софта для определенных задач, в том числе для больших языковых моделей (LLM). Будь то AMD, Intel или NVIDIA – использование оптимизированного программного обеспечения всегда приводит к значительным скачкам производительности от 30 до 100%. NVIDIA в качестве библиотеки в данном случае предлагает TensorRT-LLM.

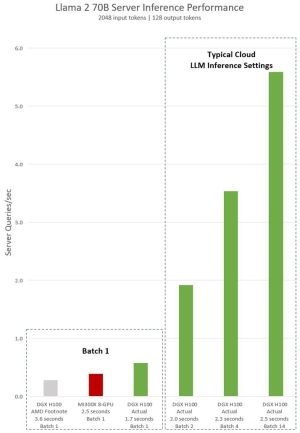

NVIDIA сравнивает цифры, представленные AMD, со своими собственными результатами. Использовалась Llama 2 70B с 70 миллиардами параметров.

NVIDIA отдельно упоминает, что AMD проводила тесты на GPU H100 без библиотеки TensorRT-LLM. То же самое верно и для восьми GPU в системе DGX-H100, которые сравнивались с системой, оснащенной восемью Instinct MI300X.

Благодаря оптимизированному программному обеспечению система DGX-H100 обеспечивает значительно меньшее время отклика, чем система с Instinct MI300X. Указываются значения от 2,5 до 1,7 секунды. NVIDIA также приводит значения для больших размеров Batch. Как правило, для оценки производительности задается фиксированное время отклика, после чего оценивается количество ответов, которое может обеспечить ускоритель. AMD пока не предоставила никакой информации на этот счет.

Конечно, производители всегда стараются представить свое оборудование в лучшем свете. Это касается как AMD, так и NVIDIA и Intel. Тот факт, что оптимизация программного обеспечения играет все более важную роль, не облегчает ситуацию. В любом случае система, состоящая из аппаратного и программного обеспечения, всегда должна учитывать взаимодействие всех факторов.

Теперь мы с нетерпением ждем первых независимых бенчмарков. Например, от MLCommons.

Обновление:

Контрудар AMD нанесла даже быстрее, чем ожидалось. Компания опубликовала новые бенчмарки, которые должны подтвердить преимущество Instinct MI300X над NVIDIA.

В новых бенчмарках AMD теперь использует TensorRT-LLM для ускорителя H100, а не vLLM, как раньше. Производительность FP16 на ускорителе Instinct MI300X сравнивается с FP8 на H100. Помимо важных задержек, AMD также указывает пропускную способность. Следует отметить, что здесь всегда использовалась система, состоящая из восьми ускорителей.

В вычислениях FP16 AMD указывает преимущество в 2,1 раза, если на обеих картах используется vLLM - это старые и ранее известные результаты AMD. Если же для ускорителя H100 используется оптимизированная TensorRT-LLM FP16, то AMD по-прежнему на 30% быстрее. Если обратиться к задержкам, для вычислений TensorRT-LLM и FP8 на H100 от NVIDIA указывается 1,7 с, а в случае собственного ускорителя Instinct MI300X заявлено время 1,6 с (хотя и с FP16).

Оценивать приведенные результаты нелегко, поскольку многое зависит от того, какое программное обеспечение и какие наборы данных используются. Потенциальные покупатели наверняка будут проводить собственные тесты. Клиенты также могут оценить обе среды через облачных провайдеров и затем принять решение в пользу того или иного оборудования для максимально эффективного использования.

Подписывайтесь на группу Hardwareluxx ВКонтакте и на наш канал в Telegram (@hardwareluxxrussia).