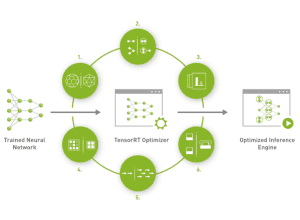

Наряду с поддержкой RTX Video Super Resolution на видеокартах серии GeForce RTX 20, NVIDIA представила программную библиотеку TensorRT-LLM для Windows. TensorRT-LLM – это библиотека с открытым исходным кодом, специально адаптированная для больших языковых моделей (Large Language Models), которая уже была представлена для ускорителей ЦОД и доступна в режиме Early Access. TensorRT-LLM еще раз показывает, что дальнейшее развитие и оптимизация программного обеспечения могут оказать не меньшее влияние на производительность LLM, чем новые ускорители.

Наряду с поддержкой RTX Video Super Resolution на видеокартах серии GeForce RTX 20, NVIDIA представила программную библиотеку TensorRT-LLM для Windows. TensorRT-LLM – это библиотека с открытым исходным кодом, специально адаптированная для больших языковых моделей (Large Language Models), которая уже была представлена для ускорителей ЦОД и доступна в режиме Early Access. TensorRT-LLM еще раз показывает, что дальнейшее развитие и оптимизация программного обеспечения могут оказать не меньшее влияние на производительность LLM, чем новые ускорители.

Благодаря TensorRT-LLM под Windows пользователи с видеокартами GeForce RTX смогут задействовать преимущества оптимизации. Локальный инференс LLM через TensorRT-LLM выполняется в четыре раза быстрее, чем без этой программной библиотеки.

TensorRT-LLM также обеспечивает преимущество в производительности при локальной тренировке. Сети LLM не справляются, когда им приходится отвечать на вопросы или обрабатывать задачи, которые они на самом деле не знают, то есть которые выходят за объем данных, использовавшихся для тренировки. В таких случае LLM склонны к фальсификации – они просто придумывают ответ на основе неверных данных. Проблему решает технология Retrieval-Augmented Generation (RAG), предоставляющая контекст вместе с вопросом/деталями задачи. Она также ускоряется с помощью TensorRT-LLM.

В ближайшее время библиотека TensorRT-LLM для Windows будет доступна на сайте разработчиков NVIDIA. Оптимизированные модели с открытым исходным кодом и демонстрация RAG будут доступны на ngc.nvidia.com и github.com/nvidia.

TensorRT-LLM для Windows и Stable Diffusion

TensorRT-LLM для Windows также ускоряет работу локальных инстанций Stable Diffusion. Даже GeForce RTX 4090 требуется от нескольких секунд до нескольких минут на вычисления, в зависимости от размера изображения и модели, но библиотека TensorRT-LLM, как утверждается, способна значительно ускорить этот процесс. По данным NVIDIA, изображения создаются в семь раз быстрее, чем на Mac с M2 Ultra.